先頃、Googleは、Compute EngineにNVIDIA Ampere A100 Tensor Core GPUに基づくA2バーチャルマシン (VM) の一般提供を発表した。同社によれば、A2 VMにより、顧客はNVIDIA CUDA対応の機械学習 (ML) とハイパフォーマンスコンピューティング (HPC) のスケールアウトおよびスケールアップワークロードを低コストで効率的に実行できるようになる。

Googleは、機械学習ワークロード向けのハイパフォーマンスコンピューティングを探している顧客向けに、昨年7月Computing Engine A2 VMを初めて導入した。このVMは、コンピューティングからアクセラレータに最適化されたマシンに至るまで、Googleの事前定義されたカスタムVMの一部だ。現在、A2 VMは、CFDシミュレーション (Altair ultraFluidXを使用) などのハイパフォーマンスコンピューティング (HPC) アプリケーションですぐに利用できる。

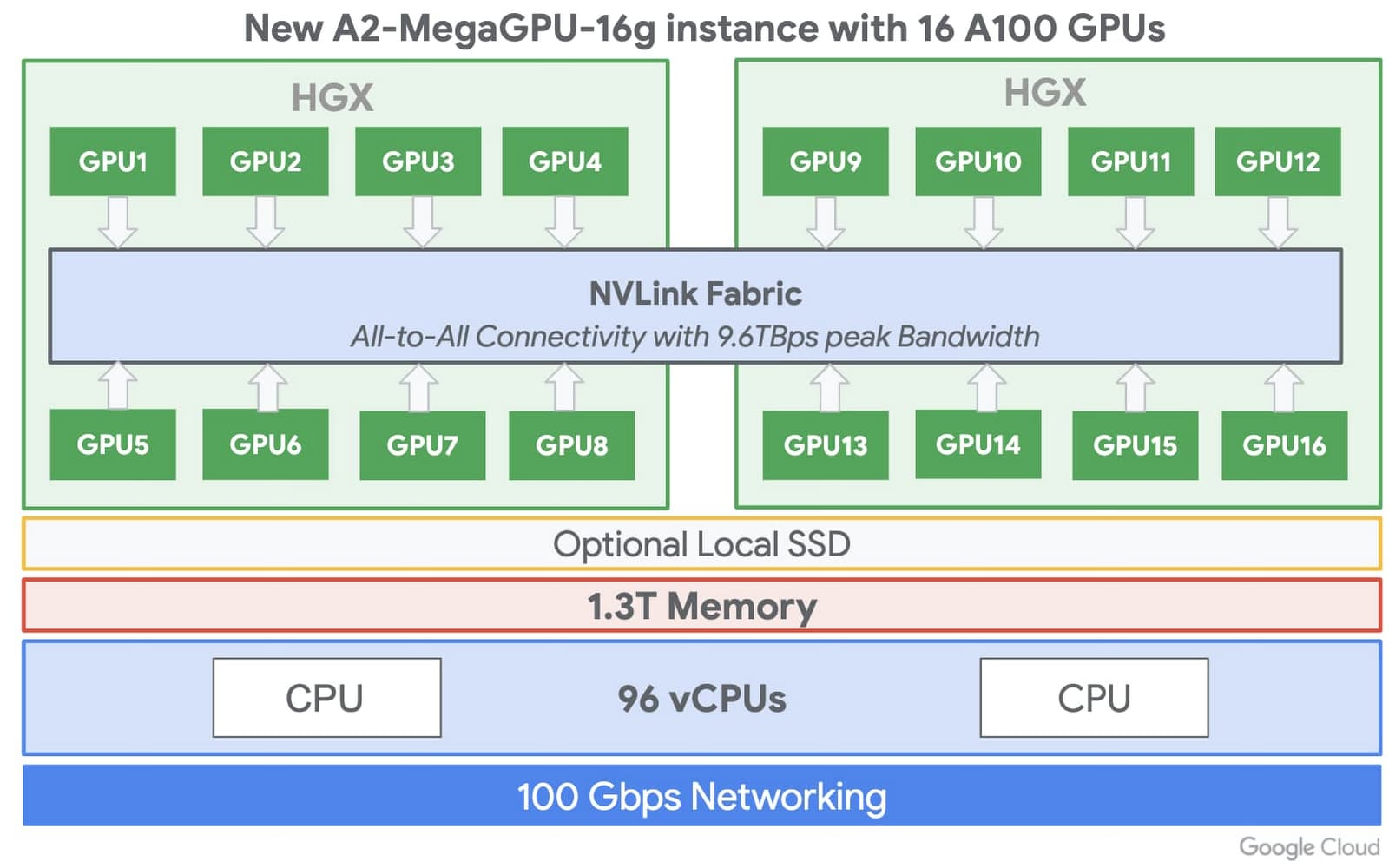

A2 VMを使用すると、顧客は小規模なGPU構成 (VMごとに1、2、4、および8GPU) とは別に、単一のVMで最大16のNVIDIA A100 GPUを選択でき、ワークロードを拡張するための柔軟性と選択肢を提供する。さらに、すべての構成を1つのVMに配置でき、単一ノードのMLトレーニング用に複数のVMを構成が不要となる。

出典: https://cloud.google.com/blog/products/compute/a2-vms-with-nvidia-a100-gpus-are-ga

A2 VMは、ドライバ、NVIDIA CUDA-X AIライブラリ、TensorFlowやPyTorchなどの一般的なAIフレームワークを含む深層学習VMイメージとしても利用できる。さらに、Googleの構築済みのTensorFlow Enterprise Imagesは、現在および古いバージョンのTensorFlow (1.15、2.1、および2.3) のA100最適化もサポートしている。

GoogleはA2ファミリーにより、MicrosoftやAWSなどの同様のサービスを提供する他のパブリッククラウドベンダーとともに、市場で事前定義されたカスタムVMへの投資を増やしている。Constellation Research Inc. の主席アナリスト兼副社長であるHolger Mueller氏は、InfoQに次のように語っている:

クラウドベンダーはプロプライエタリのクラウドAIプラットフォームでAI / MLワークロードを実行するのが大好きですが、企業はその潜在的なロックインを回避したいと考えています。Nvideiaによる重要な偉業は、すべての主要なクラウドプラットフォームでAmpereを実行し、クラウド全体でモデルの移植性を顧客に提供し、マルチクラウドでAI / MLを効果的に有効にしたことです。最新のAmpereプラットフォームを採用するビッグ3のIaaSベンダーの中でGoogleが最初であることは驚くことではありません。ナンバー3のIaaSベンダーとしては、より大きな競合他社よりも速く動く必要があったためです。

現在、NvidiaのA100 GPUを搭載したA2インスタンスは、us-central1、asia-southeast1、europe-west4リージョンで利用可能であり、今年後半にはさらに多くのリージョンでオンラインになる。A2 VMは、オンデマンド、プリエンプティブ、およびコミットされた使用割引を介して利用できる。そして最後に、A2インスタンスは、Compute EngineのGoogle Kubernetes Engine、Cloud AI Platformやその他のサービスによって完全にサポートされている。